欢迎参与评论,每一条合规评论都是对我们的褒奖。

请 登录 或 快速注册 后发表评论

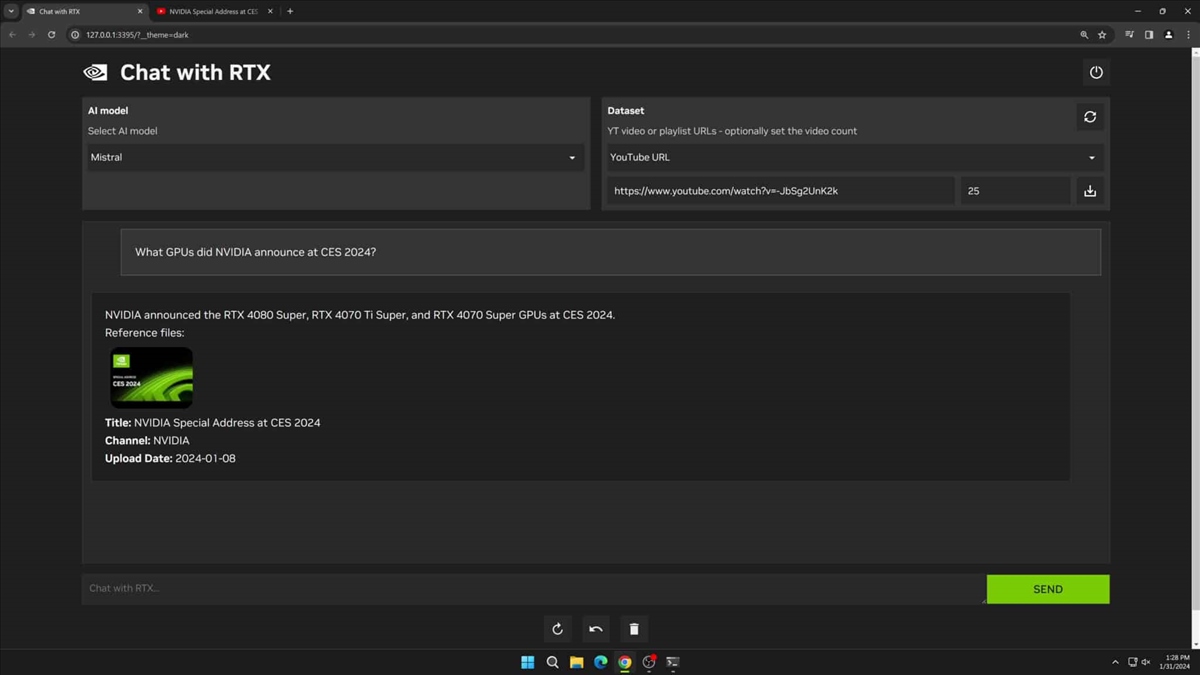

像ChatGPT这种AI助手都挺好用的,不过用户需要联网才能够访问它们。虽然本地部署LLM也是可以的,但是多半比较麻烦。而近日,NVIDIA推出了一种较为方便的本地部署AI助手的方式,名为Chat with RTX。

NVIDIA在官方博客中表示,Chat with RTX是一个技术演示应用,可以让用户以自己的内容定制一个聊天机器人。这个应用结合了检索增强生成、TensorRT-LLM和NVIDIA RTX加速技术。用户可以把PC上的本地文件作为数据集连接到开源的LLM如Mistral或Llama 2上,这样就能询问AI获得答案和相关的文件,而不必自己动手寻找。NVIDIA表示,Chat with RTX支持.txt,.pdf,.doc/docx,.xml等多种文件类型,只需要给出文件夹路径,AI就会在数秒内把它们加载到库中。

另外,用户还可以让AI理解并提取Youtube视频中的内容(至少NVIDIA是这样说明的,不知道是否支持更多网站),只需要添加Youtube视频或者播放清单的URL,就可以向AI提问,比如说让它总结视频内容。这里说明一下,虽然这个操作需要访问网络,但是AI的运算是全程在本地进行的。

至于配置要求的话,用户需要一张8GB显存起步的RTX 30或40系显卡(反正是Ampere和Ada Lovelace两代GPU就行),16GB以上的内存,Windows 11系统和535.11及更新的驱动。就显存这块来说要求也不算特别高。占用空间方面,用户需要下载35.1GB文件。感兴趣和配置要求及格的用户可以点击【该链接】直接下载体验。