关于 HBM2 的消息

AMD宣布Alveo V80计算加速卡量产:配32GB HBM2E,针对内存密集型工作负载

AMD宣布,Alveo V80计算加速卡已进入量产阶段,这是针对内存密集型工作负载的最新高性能计算(HPC)产品。作为基于FPGA的加速器,Alveo V80有望通过极具竞争力的性能和定价来争夺严重依赖内存利用率的中端工作负载市场,被HPC、数据分析、金融、网络安全和存储应用领域大规模采用。

国内HBM开发取得进展:两家存储器制造商跟进,目标2026年生产HBM2

近年来高带宽内存的需求急剧上升,随着人工智能(AI)热潮的到来,让这一趋势愈加明显。三星、SK海力士和美光是HBM市场的三大巨头,目前都在加速开发新产品,并积极地扩张产能。

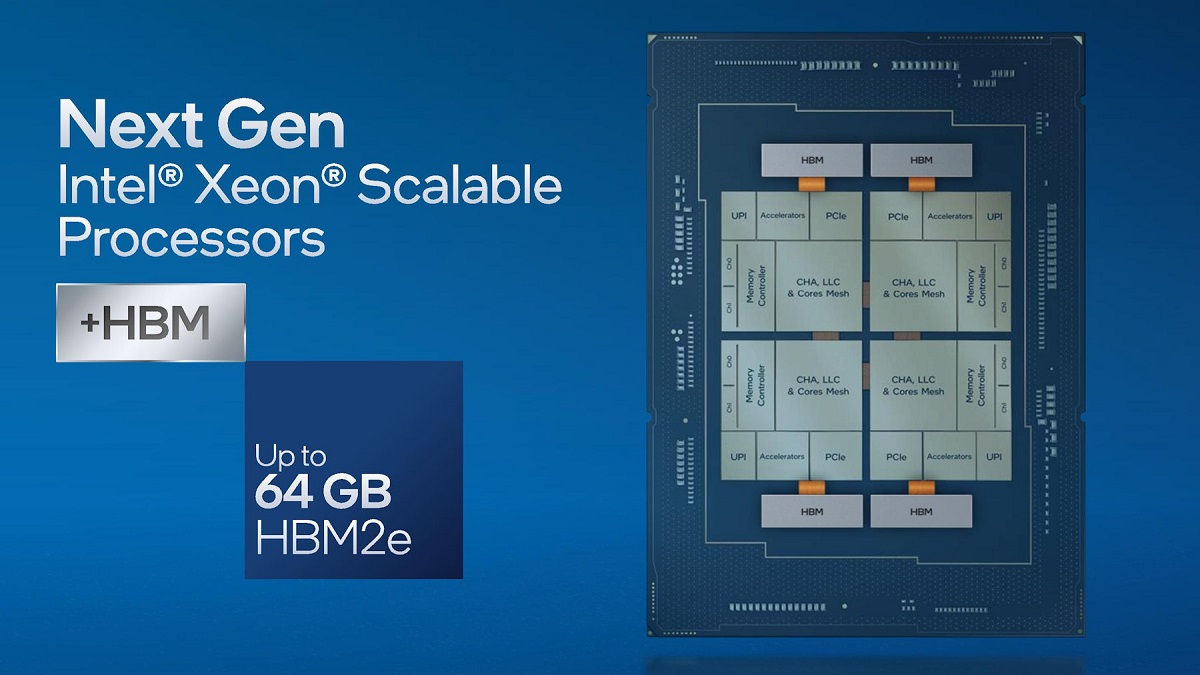

英特尔表示Sapphire Rapids将有64GB HBM2e,并确认Ponte Vecchio缓存容量

在近日举行的Supercomputing 2021上,英特尔进一步披露了称为Sapphire Rapids的新一代至强(Xeon)可扩展处理器的信息。

AMD Instinct MI200将会配备256个CU和128GB HBM2e

AMD首席执行官苏姿丰博士在上个月摩根大通举办的第49届全球技术、媒体和通信大会上,已确认代号为Aldebaran的CDNA 2架构GPU将会在年内推出。这款很可能名为Instinct MI200的计算卡,是专门为计算密集型和HPC工作负载而设计。

英伟达发布全新HGX A100系统,以及配备80GB HBM2e显存的A100 PCIe计算卡

英伟达宣布将通过人工智能与高性能计算相融合的新技术为HGX AI超级计算平台注入动力,使超算可以为更多行业服务。

英伟达将发布配备80GB HBM2e显存的A100 PCIe版计算卡

在去年5月份,英伟达GTC 2020上推出了基于新一代Ampere架构的A100计算卡,其面积高达826mm²的GA100核心采用台积电7nm工艺制造。A100计算卡有两种不同形态,一种是SXM4版,另一种是通用规格的PCIe版,后者仅限于两块GPU通过NVLink互联。

SK海力士预计HBM3会有665GB/s带宽,比HBM2E提高了44.6%

高带宽存储器(High Bandwidth Memory)也就是平常称为HBM的DRAM,是基于3D堆栈工艺的高性能DRAM,适用于高存储器带宽需求的应用场景。虽然HBM没有成为显卡的主流DRAM,但是在需要高带宽的数据中心等领域,仍不时见到其身影。近日SK海力士(SK Hynix)公布了HBM3的产品计划,介绍了即将推出的规范和预期带宽等信息。

英特尔两款Arctic Sound系列计算卡遭曝光,采用HBM2e显存

在过去的一年多的时间里,英特尔不时地提及其Xe-HP架构GPU,Raja Koduri也经常在推特上分享各种消息。虽然曝光率不低,但是基本不会太多涉及到具体上市时间、架构信息和产品规格等细节。

三星推出“会思考”的HBM2内存,具备1.2 TFLOPS嵌入式计算能力

三星宣布推出新款HBM2内存,其中集成了AI处理器,最高可提供1.2 TFLOPS嵌入式计算能力,使内存芯片本身可以执行CPU、GPU、ASIC或FPGA的操作。

英伟达发布A100 80GB HBM2e加速卡,应对AMD威胁

据HOTHAREDWARE报道,英伟达官方发布了基于Ampere架构的A100已经被认为是高性能计算集群(HPC)的首选GPU,但为了巩固自身在行业之中的位置,特别是竞争对手AMD发布了基于新一代CDNA架构的Instinct MI100加速卡,英伟达推出了搭载80GB HBM2e大容量显存版的A100。

SK海力士宣布启动HBM2E DRAM的量产,等效频率跑在3.6Gbps

HBM DRAM拥有超高的数据带宽,是计算密集型芯片的不二之选。我们也看到这种类型的DRAM在各种计算卡、AI加速器等领域中有着越来越广泛的应用,这也推动着它继续升级迭代。去年三星和SK海力士都宣布自己开发出了HBM2内存的小幅升级版本,即HBM2E内存,今天SK海力士终于正式宣布他们开始量产HBM2E内存了。

三星下一代DDR5和HBM3内存会集成AI引擎,PIM技术将进一步扩展

在今年二月初,我们报道了三星新的HBM2内存将集成AI引擎,HBM-PIM(Aquabolt-XL)芯片最高可提供1.2 TFLOPS嵌入式计算能力,使内存芯片本身可以执行CPU、GPU、ASIC或FPGA的操作。近日,三星在Hot Chips 33上介绍了未来更为庞大的开发计划,会将PIM (processing-in-memory) 技术扩展到DDR4、DDR5、LPDDR5X、GDDR6和HBM3内存上。

三星推出“会思考”的HBM2内存,具备1.2 TFLOPS嵌入式计算能力

三星宣布推出新款HBM2内存,其中集成了AI处理器,最高可提供1.2 TFLOPS嵌入式计算能力,使内存芯片本身可以执行CPU、GPU、ASIC或FPGA的操作。

美光计划于年内发售HBM2 DRAM,同时将开始DDR5试样

作为三大DRAM供应商之一的美光将他们的HBM2搁置了很久,目前的市场上,SK海力士和三星都已经推出了HBM2产品,甚至已经发展了多代。不过美光在最近的财务会议上面透露,他们将会在年内发售HBM2显存:

AMD Arcturus加速卡BIOS流出:32GB HBM2显存,功耗仅为200W

AMD现在的Radeon Instinct MI6加速卡还是2017年发布的,采用的还是北极星架构。此前有消息透露称其下一代的高性能计算加速卡将采用名为Arcturus的新架构,首张Arcturus加速卡将被命名为Radeon Instinct MI100首次亮相,techpowerup已经访问了它的BIOS代码,该份BIOS确认了“ Arcturus”这个名称,并且还确认了其将具有32GB HBM2显存。

- 12024年4月中国大陆显卡出货量:华硕逆势增长重回第二

- 2酷冷至尊推出全新Cryofuze 5导热膏:为DIY带来新趣味与个性化选择

- 3联力DAN Cases A3-mATX机箱图赏:设计简约典雅,装法丰富多样

- 4影驰推出RTX 4070 SUPER/Ti SUPER Classic显卡,双槽涡轮散热设计

- 5UL揭示8年GPU性能发展历程:平均性能提高1.8倍,未来需要更大压力的测试

- 6酷里奥B40S-DIG系列散热器上架:133mm高度,10CM风扇,配温度数显

- 7JEDEC概述未来内存标准:DDR6速率将飙升至17.6Gbps

- 8618精选:技嘉心动购物节开启,主板早买也便宜

- 9PowerToys引入AI粘贴功能,可理解剪贴板内容并进行输出